Spark Map函数

Spark Map函数

在Spark中,Map将源数据的每个元素通过一个函数进行处理,并生成一个新的分布式数据集。

Map函数的示例

在这个示例中,我们为每个元素加上一个常量值10。

- 要以Scala模式打开Spark,请执行以下命令

$ spark-shell

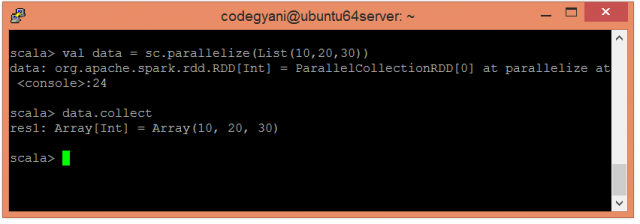

- 使用并行集合创建RDD。

scala> val data = sc.parallelize(List(10,20,30))

- 现在,我们可以使用以下命令来读取生成的结果。

scala> data.collect

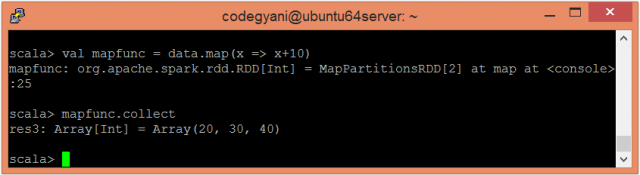

- 应用map函数并传递所需执行的表达式。

scala> val mapfunc = data.map(x => x+10)

- 现在,我们可以使用以下命令来读取生成的结果。

scala> mapfunc.collect

这里,我们得到了期望的输出。

本文链接:http://so.lmcjl.com/news/20175/

展开阅读全文

上一篇:python求平方的函数语句是

下一篇:广州活动场地租赁合同【五篇】

相关内容